Présentation du séminaire

L’Intelligence Artificielle (IA) est parfois présentée comme la solution à venir pour des problèmes trop complexes pour être adéquatement appréhendés par l’être humain, ou bien considérée comme une façon d’échapper à des tâches rébarbatives et inutilement coûteuses, y compris dans les activités de recherche. L’IA serait aussi une aide à la décision performante, capable d’accélérer nos choix, indispensable pour réduire les hésitations inutiles et les erreurs dangereuses, comme dans le domaine médical. Elle ouvrirait la voie à de nouvelles façons d’appréhender les données nombreuses et disparates.

Inversement, l’IA est aussi source de craintes multiples et de critiques sérieuses. Elle est accusée d’être une source de destruction d’emplois, de générer un travail avilissant pour entrainer l’apprentissage de ce type d’outil. Des études ont montré que l’IA perpétuait souvent les stéréotypes et favorisait donc la reproduction de tendances critiquables, voire les amplifiait. En plus de son coût social, elle aurait un coût environnemental non négligeable du fait des nombreux serveurs nécessaires pour son entrainement et son fonctionnement. La diffusion de l’IA dans le milieu académique, comme dans la vie de tous les jours, interroge.

L’utilisation croissante de l’Intelligence Artificielle dans la société et dans le monde de la recherche conduit-elle à des changements de pratiques profonds et à des méthodes de validation nouvelles ? En recherche, n’est-elle qu’un moyen d’accéder plus facilement à des financements ou un outil fécond pour élaborer des connaissances avec des approches différentes ? Quelles incertitudes, quelles reproductibilités, quels impacts environnementaux directs et indirects, quelles responsabilités, quels droits d’auteur découlent de l’usage de l’IA ? L’IA est-elle un pas en direction de l’affaiblissement de la réduction des libertés, de la reproduction amplifiée des stéréotypes et des pratiques préexistantes, de la diminution de la créativité ou une révolution qui améliorera les conditions de vie de tous ?

Les questions soulevées pendant ce séminaire sont organisées en six séances de février à juin.

Séances*

Séance 1 : Qu’est-ce que l’IA ? Définition et matérialité

Séance 2 : Impact de l’IA sur le travail

Séance 3 : Impact de l’IA sur la recherche en médecine

Séance 4 : L’IA est-elle discriminante : Sexisme, racisme, inégalités ?

Séance 5 : De l’histoire passée aux perspectives futures : Quel rôle pour l’IA ?

* Cliquez sur une séance pour accéder au contenu

Séance 1 : 13 Février

Qu’est-ce que l’IA ? Définition et matérialité

Présentations de Daniel Andler et Fabrice Flipo suivies d’un débat animé par Guillaume Roux, Maître de conférence en Physique, Université Paris-Saclay et par Julien Gargani, Directeur du Centre d’Alembert.

Intervenants :

Daniel Andler, est professeur émérite de l’Université de la Sorbonne, il a été titulaire de la chaire de philosophie des sciences et d’épistémologie de l’Université Paris-Sorbonne (Paris IV). Il travaille au Département d’études cognitives qu’il a fondé à l’Ecole normale supérieure en 2001. Il est membre honoraire de l’Institut universitaire de France. En décembre 2016, il a été élu à l’Académie des sciences morales et politiques.

L’intelligence artificielle : ce qu’elle vise, ce qu’elle fait

Après avoir connu des hauts et des bas, l’intelligence artificielle semble inscrite désormais sur une trajectoire victorieuse : rien ne semble pouvoir lui échapper. Non seulement elle conquiert, l’un après l’autre, des domaines — les échecs, le jeu de go, la science, l’organisation du quotidien, la gestion des villes, la diffusion de l’information, l’art de la guerre — qui ont longtemps semblé réservés à l’intelligence humaine, mais avec ChatGPT et l’IA générative, elle semble en mesure de la rattraper d’un coup d’un seul.

L’intelligence artificielle oscille depuis l’origine entre trois conceptions. Selon la première, aujourd’hui minoritaire, elle est liée à l’intelligence humaine à la manière dont une copie est liée à ce dont elle est copie ; selon la deuxième, plus largement acceptée, elle n’a pour ambition que de se substituer peu à peu à l’intelligence humaine, permettant peut-être à terme de s’en passer complètement. Ces conceptions reposent sur une méprise : les produits de l’IA n’appartiennent pas à la même catégorie d’entités que l’intelligence humaine. Ils sont impressionnants, ils peuvent être utiles et dangereux. Mais ce sont des outils, ce ne seront jamais des collègues : cette troisième conception nous met à l’abri d’illusions qui constituent elles-mêmes un danger.

Fabrice Flipo est professeur de philosophie, travaillant dans le domaine des sustainability studies. Il est chercheur au Laboratoire de Changement Social de l’Université de Paris Cité. Il s’intéresse notamment aux infrastructures écologiques du numérique, avec Peut-on croire aux TIC vertes ? (Presses des Mines, 2009), L’impératif de la sobriété numérique (Matériologiques, 2020).

Écologie de l’infrastructure numérique

Alors que Google avait un objectif de neutralité carbone, l’IA a fait grimper ses émissions de 50%. Le secteur du numérique est aujourd’hui celui qui a la pire trajectoire de tous, en termes de GES. Il pourrait tripler ses émissions d’ici 25 ans, voire davantage si l’efficacité énergétique ralentit. Alors que les catastrophes climatiques se multiplient, l’intervention brossera un tableau rapide de la situation, en posant une question : les « bienfaits » de l’IA valent-ils réellement le coût ainsi engagé ?

Questions du public, débat animé par Julien Gargani et Guillaume Roux

Séance 2 : 18 mars

Impact de l’IA sur le travail

Présentations de Paola Tubaro, Flore Barcellini et Moustafa Zouinar suivies d’un débat animé par Hélène Gispert, Université Paris Saclay, Samuel Roturier, UVSQ et Julien Gargani, Directeur du Centre d’Alembert.

Paola Tubaro est directrice de recherche au CNRS et enseigne à l’ENSAE. Au croisement de la sociologie économique, de l’analyse des réseaux sociaux et de l’informatique, elle étudie actuellement les chaînes de production de l’intelligence artificielle, les mécanismes sociaux de diffusion de la désinformation en ligne, et l’éthique des données et de la recherche sociale.

D’où vient l’IA ? Le travail mondialisé derrière l’automation

Résumé : Le travail joue un rôle majeur, bien que largement méconnu, dans le développement de l’intelligence artificielle (IA). Les algorithmes d’apprentissage automatique reposent sur des processus à forte intensité de données qui font appel à des humains pour exécuter des tâches répétitives et difficiles à automatiser, et pourtant essentielles, telles que l’étiquetage d’images, le tri d’éléments dans des listes et la transcription de fichiers audio. Des réseaux de sous-traitants recrutent des « travailleurs de la donnée » pour exécuter ces tâches, souvent dans des pays à faible revenu où les marchés du travail stagnent et l’économie informelle domine. Nous regarderons de plus près les conditions de travail et les profils des travailleurs et travailleuses de la donnée au Brésil, au Venezuela, et à Madagascar. Les chaînes d’approvisionnement mondialisées qui relient ces travailleurs et travailleuses aux principaux sites de production de l’IA prolongent les dépendances économiques de l’époque coloniale et renforcent les inégalités héritées du passé.

Flore Barcellini est Professeure des Universités en Ergonomie au Cnam. Elle est directrice du Centre de Recherche sur le Travail et le Développement. Elle a coordonné le rapport « Le travail et l’emploi à l’épreuve de l’IA : Etat des lieux et analyse critique de la littérature » dans le cadre d’un contrat de recherche avec la CGT-FO dans le cadre de l’agence d’objectifs de l’Institut de Recherche Economique et Sociale (https://ires.fr/publications/cgt-fo/le-travail-et-lemploi-a-lepreuve-de-lia-etat-des-lieux-et-analyse-critique-de-la-litterature/).

Moustafa Zouinar est Professeur associé en ergonomie au CNAM-CRTD et chercheur ergonome dans le département de recherche en sciences humaines et sociales d’Orange (SENSE), Moustafa Zouinar mène des recherches autour de : l’analyse des usages de dispositifs techniques numériques dans des contextes variés et des transformations occasionnés par ces usages sur le plan de l’activité, l’interaction Humain-machine, et la conception des systèmes interactifs. Actuellement, ses travaux portent principalement sur les Systèmes d’Intelligence Artificielle, leur déploiement et usages dans les milieux professionnels, leurs conséquences sur le travail, et leur conception.

Le travail à l’épreuve de l’IA.

Résumé : Flore Barcellini et Moustafa Zouinar présenteront une analyse critique des discours et des recherches en cours sur les transformations du travail permettant de dépasser les discours simplistes sur les bénéfices de l’automatisation dans le contexte du développement de l’IA dans les milieux de travail. Cette analyse reviendra sur certains bénéfices de l’IA en termes de gain de performance, les transformations constatées qui seront complétées par une mise en garde sur les effets contre-productifs et les risques de l’IA pour le travail (complexification du travail, incertitude, augmentation de la charge de travail, subordination accrue, baisse de la fiabilité des actions, perte de sens du travail, diminution de la créativité et d’uniformisation de la pensée et des produits, perte du développement de compétences et de l’expertise, etc.). Elle mettra en lumière l’importance cruciale des choix organisationnels et de la participation des travailleurs dans le déploiement de l’IA en soulignant que les effets des usages de l’IA sur le travail ne sont pas prédéterminés, mais dépendent largement des décisions prises par les entreprises/institutions et les acteurs sociaux et de la valeur qui est donné à l’expérience des professionnels et au travail réel. Pour conclure, les auteurs préconiseront une approche basée sur quatre piliers pour développer des usages soutenables de l’IA, favorables au travail et aux salariés: le développement de la capacité d’apprentissage des organisations, un dialogue social renouvelé, des conduites de projet participatives et donnant une valeur à l’expérience des professionnels, et l’organisation et la documentation des expérimentations d’usage in situ des SIA.

Questions du public débat animé par Hélène Gispert, Univ. Paris Saclay, Samuel Roturier, UVSQ et Julien Gargani, Directeur du Centre d’Alembert.

Séance 3 : 31 mars

Impact de l’IA sur la recherche en médecine

Présentations de Stéphanie Allassonnière et Pierre-Antoine Gourraud suivies d’un débat animé par Ioana Manolescu-Goujot, Directrice de recherche à l’INRIA, professeure chargée de cours à l’Ecole Polytechnique et Julien Gargani, Directeur du Centre d’Alembert.

Stéphanie Allassonnière est Professeur de mathématiques appliquées à l’UFR de médecine de l’université Paris Cité et Vice-Présidente en charge de l’innovation et la valorisation.

Intelligence artificielle en santé : actualités et perspectives ?

Résumé : Je présenterai tout d’abord rapidement le contexte général de l’intelligence artificielle en santé ainsi que les possibles limites. Ensuite je focaliserai sur une question particulière qui est la médecine de précision et les questions mathématiques qui en émergent. Je présenterai ensuite au choix parmi quatre cas d’usages celui (ou ceux) qui auront le plus d’intérêt pour l’auditoire. Les cas d’usage sont : utilisation des LLM, jumeau numérique, cohortes augmentées et optimisation de la conduite d’examen. Chaque exemple sera concrétisé par une présentation d’un outil déjà utilisé par les professionnels du secteur.

Pierre-Antoine Gourraud est professeur des universités en médecine à Nantes Université et praticien-hospitalier au CHU de Nantes. Auteur (h-index de 59) de plus de 180 publications cumulant plus de 13 500 citations, ses activités de recherche se positionnent au carrefour de l’immunologie, de la génétique et du traitement informatique des données de santé. Enseignant versé dans la bio-informatique et la biologie cellulaire, il pratique les ressources éducatives libres depuis plus de 10 ans avec le MOOC de Biologie cellulaire « Cellules & Cellules Souches » et le parcours d’anglais médical « Road 66 to Medical English ».

Mise en œuvre d’un entrepôt de données biomédicales :

De la conception à l’application clinique dans un centre hospitalier universitaire français régional – Dévoiler les processus, surmonter les défis et extraire des connaissances cliniques

Résumé : L’exploitation des données de santé est un enjeu majeur pour la recherche et la prise de décision clinique. Cette conférence propose un retour d’expérience sur la mise en place de l’entrepôt de données biomédicales (EDB) du CHU de Nantes, de sa conception à son utilisation effective. Nous aborderons les défis rencontrés : transformation organisationnelle, architecture technique, gouvernance des données et conformité réglementaire. Nous explorerons également l’impact de cet outil sur la recherche et l’aide à la décision, en illustrant son potentiel par des exemples concrets. Enfin, nous discuterons du rôle central de la gouvernance des données dans une stratégie institutionnelle intégrant les professionnels de santé et les patients.

Questions du public, débat animé par Ioana Manolescu-Goujot et Julien Gargani.

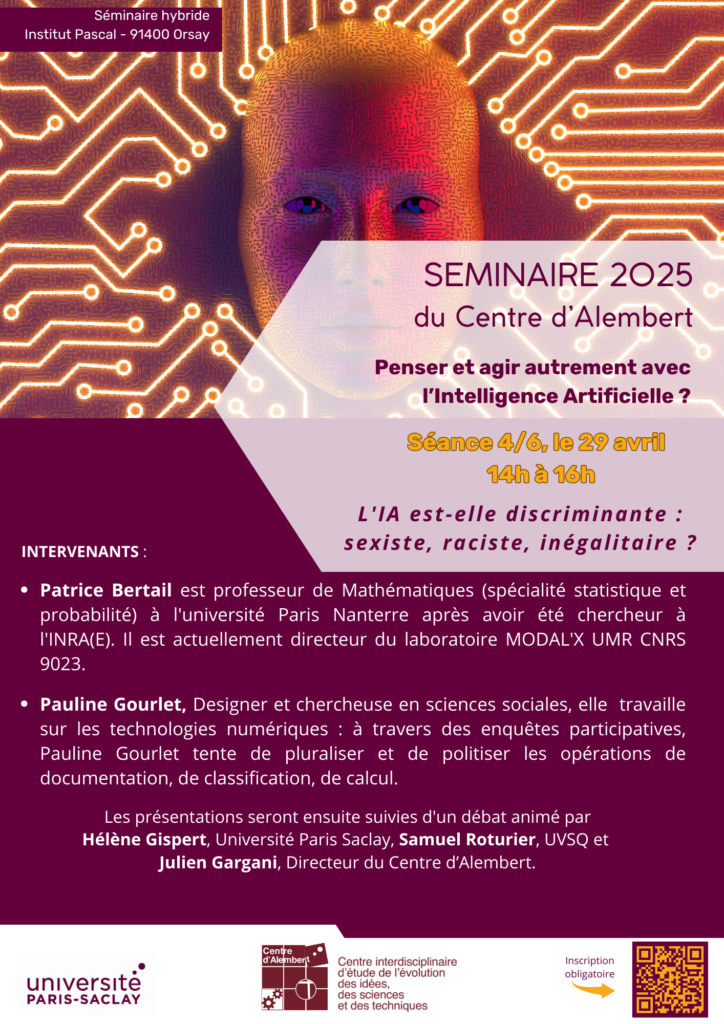

Séance 4 : 29 avril

L’IA est-elle discriminante :

Sexisme, racisme, inégalités ?

Présentations de Patrice Bertail et Pauline Gourlet suivies d’un débat animé par Hélène Gispert, Université Paris Saclay, Samuel Roturier, UVSQ et Julien Gargani, Directeur du Centre d’Alembert.

Patrice Bertail est professeur de Mathématiques (spécialité statistique et probabilité) à l’université Paris Nanterre après avoir été chercheur à l’INRA(E). Il est actuellement directeur du laboratoire MODAL’X UMR CNRS 9023. Il a enseigné dans de nombreux pays, dont les États-Unis, Hong-Kong, le Bénin, la Côte d’Ivoire, Cuba etc… Ses travaux de recherche portent sur les méthodes de statistiques non-paramétriques et les méthodes de rééchantillonnage, les processus empiriques, les chaînes de Markov et l’apprentissage statistique. Il a également réalisé des travaux plus appliqués sur l’évaluation des risques alimentaires. Ses travaux récents portent surtout sur l’apprentissage statistique et l’IA dans un cadre dépendant et les corrections de biais dans ce cadre.

Biais en apprentissage statistique : une revue et une approche

semi-paramétrique par calibration

Résumé : Dans cette présentation, nous passons d’abord en revue quelques types de biais pouvant apparaître fréquemment dans des problèmes d’apprentissage statistique : biais de données, biais de sélection, biais d’endogénéité, biais de modèle dans les cas non-stationnaires, biais cognitifs etc… Ces types de biais sont bien connus dans la littérature statistique et plus encore en économétrie mais pas toujours pris en compte en apprentissage. Ces problèmes de biais posent non seulement des problèmes techniques mais aussi éthiques comme nous le verrons sur quelques exemples. Les techniques de corrections de biais sont souvent inspirées de technique de sondage et reposent sur des pondérations adéquates des individus : Vardi dans les année 80’s a même donné des conditions nécessaires et suffisantes pour pouvoir corriger de biais (essentiellement de sélection ou d’endogénéité) en présence d’information transversales et/ou marginales. Nous nous intéressons dans une seconde partie au problème de l’apprentissage par transfert (« Transfert Learning ») et montrons comment l’incorporation d’un modèle semi-paramétrique permet de corriger des biais à partir de l’observation de quelques moments : l’idée est très proche de la calibration ou du calage sur marge en sondage, les poids permettant de correctement repondérer les risques.

Pauline Gourlet, Chercheuse associée au médialab de Sciences Po et co-fondatrice du collectif de design L’atelier des chercheurs, Pauline Gourlet travaille à l’intersection de la recherche en design, de l’ergonomie et des STS (études des sciences et des techniques). Ses travaux portent sur le développement situé de dispositifs numériques dont elle étudie les effets, notamment sur l’action collective et les processus décisionnels. Au cours de recherches-actions réalisées dans des contextes variés (de l’école primaire aux Nations-Unies), elle expérimente des dispositifs d’enquêtes participatives et des pratiques collectives de description, en vue de pluraliser et de politiser les problèmes de la numérisation, du calcul et des modes de documentation.

Racisme, sexisme et inégalités : IA et dépossession

Résumé:

Poser la question des « bonnes manières » de calculer pour prévenir toute forme de discrimination est évidemment nécessaire et ce problème a toute sa place dans les conversations sur les développements de l’IA. Mais cette critique interne du système technique se fait souvent au détriment de — même, tend à rendre inaudible — une autre conversation : celle des conditions d’existence des techniques computationnelles. L’enjeu de cette présentation sera de montrer en quoi les développements de l’IA reposent sur des mécanismes de dépossession et perpétuent une organisation sociale raciste, sexiste et largement inégalitaire. Inspirée notamment par les théories féministes de la reproduction sociale, je décrirai trois opérations pour décaler les problèmes de « l’IA », avec un objectif proprement génératif : celui de réouvrir des options de développement technique qui se soucient du renouvellement du monde et de la justice.

Questions du public, débat animé par Hélène Gispert, Université Paris Saclay et Julien Gargani, Directeur du Centre d’Alembert.

Séance 5 : le 28 mai

De l’histoire passée aux perspectives futures :

Quel rôle pour l’IA ?

Présentations d’Ariel Kyrou suivie d’un débat animé par Gianni Giardino, Physicien, Enseignant-Chercheur UVSQ et Julien Gargani, Directeur du Centre d’Alembert.

Ariel Kyrou utilise les œuvres de l’imaginaire, qu’il mêle à des sources philosophiques ou artistiques, pour penser et panser notre aujourd’hui sous un regard qui se voudrait terrestre, solidaire voire libertaire. Il a signé en 2024 deux essais : Philofictions, Des imaginaires alternatifs pour la planète aux Éditions MF ; et avec Jérôme Vincent Pourquoi lire de la science-fiction et de la fantasy (et aller chez son libraire), chez ActuSF qui a aussi publié ses deux livres références Dans les imaginaires du futur (2020, poche chez Hélios en 2023) et ABC Dick (2021, réactualisation très augmentée de sa première version de 2009). Coscénariste du film documentaire Les mondes de Philip K. Dick (Nova Prod, Arte, 2016), il est aussi l’auteur de L’emploi est mort, vive le travail ! (Mille et Une Nuits / Fayard, 2015) avec Bernard Stiegler, de Google God (Inculte, 2010), de Paranofictions (Climats, 2007) ou encore de Techno Rebelle, Un siècle de musiques électroniques (Denoël, 2002). Il fait aujourd’hui partie de l’équipe de rédaction en chef de la revue Multitudes, et il enseigne les culturelles actuelles et les imaginaires du futur en Master de médiation culturelle et scientifique à l’Université de Versailles Saint-Quentin en Yvelines. Enfin, il a conçu et écrit le module sonore sur les imaginaires de l’IA de l’exposition « Intelligence artificielle », au Palais de la Découverte à Paris du 11 juin au 5 octobre 2025 – après avoir été créée puis exposée sous le titre « IA Double Je » par le Quai des savoir à Toulouse en 2024.

Et si les imaginaires de l’IA étaient des antidotes à ses poisons ?

Résumé : Aujourd’hui omniprésente, l’intelligence artificielle mérite à la fois d’être expérimentée, critiquée et mise à bonne distance. Recourir à ses imaginaires, qui datent d’au moins le Dieu forgeron Héphaïstos dans l’Iliade, est une première clef. Autre sésame essentiel : revenir aux sources des inspirations de celles et ceux qui nous imposent désormais leurs dites intelligences artificielles. Saviez-vous, par exemple, que l’implant neural dont rêve Elon Musk avec sa société Neuralink, permettant dans ses songes du futur de connecter nos cerveaux directement à nos IA, a été inventé de façon beaucoup plus critique par l’écrivain de science-fiction Iain M. Banks dans sa série de romans de La Culture ? Enfin, penser et agir autrement avec l’IA suppose des œuvres de philofiction, c’est-à-dire de fictions qui ouvrent plutôt qu’elles ne ferment nos devenirs, ainsi que des dispositifs mettant en boîte les algorithmes tels ceux des artistes contemporains Hito Steyerl ou Grégory Chatonsky. Soyons tout contre l’IA dans tous les sens du terme.

1/ Introduction présentée par Julien Gargani, Directeur du Centre d’Alembert et Gianni Giardino, Physicien, Enseignant-Chercheur à l’UVSQ.

2/ Présentation d’Ariel Kyrou

3/ Questions du public, débat animé par Gianni Giardino, Physicien, Enseignant-Chercheur UVSQ et Julien Gargani, Directeur du Centre d’Alembert.

Organisateurs :

Ioana Manolescu-Goujot, Directrice de recherche à l’INRIA, professeure chargée de cours à l’Ecole Polytechnique, Gianni Giardino, Physicien, Enseignant-Chercheur à l’UVSQ, Hélène Gispert, Université Paris Saclay, Pierre Nicolas, Directeur de Recherche INRAE (MaIAGE, Jouy-en-Josas), Samuel Roturier, UVSQ et Julien Gargani, Directeur du Centre d’Alembert.

📩 Contact : centre.dalembert@universite-paris-saclay.fr